Hồi đầu năm, chính phủ Mỹ đã thành lập AISIC, Liên đoàn an toàn trí tuệ nhân tạo. Apple là một trong những thành viên của AISIC. Đến thời điểm hiện tại, các nhà lập pháp và hành pháp Mỹ lại có động thái mới để kiểm soát cách những thuật toán AI và những dịch vụ dựa trên thuật toán AI vận hành.

Hồi đầu năm nay, chính quyền tổng thống Joe Biden đã đề xuất một gói những quy định quản lý những sản phẩm và dịch vụ dựa trên công nghệ AI tạo sinh, do phó tổng thống Kamala Harris công bố. Ở thời điểm hiện tại, tuân thủ theo những quy định quản lý này vẫn đang là “tùy chọn”, không phải một đạo luật với những điều khoản mà những công ty tư nhân bắt buộc phải tuân thủ khi vận hành trên đất Mỹ. Nhưng hiện giờ, hầu hết mọi tập đoàn và đơn vị nghiên cứu AI lớn tại Mỹ đều tình nguyện tuân thủ những hướng dẫn quản lý vận hành AI an toàn: Apple, Amazon, Google, Meta, OpenAI và cả Microsoft nữa.

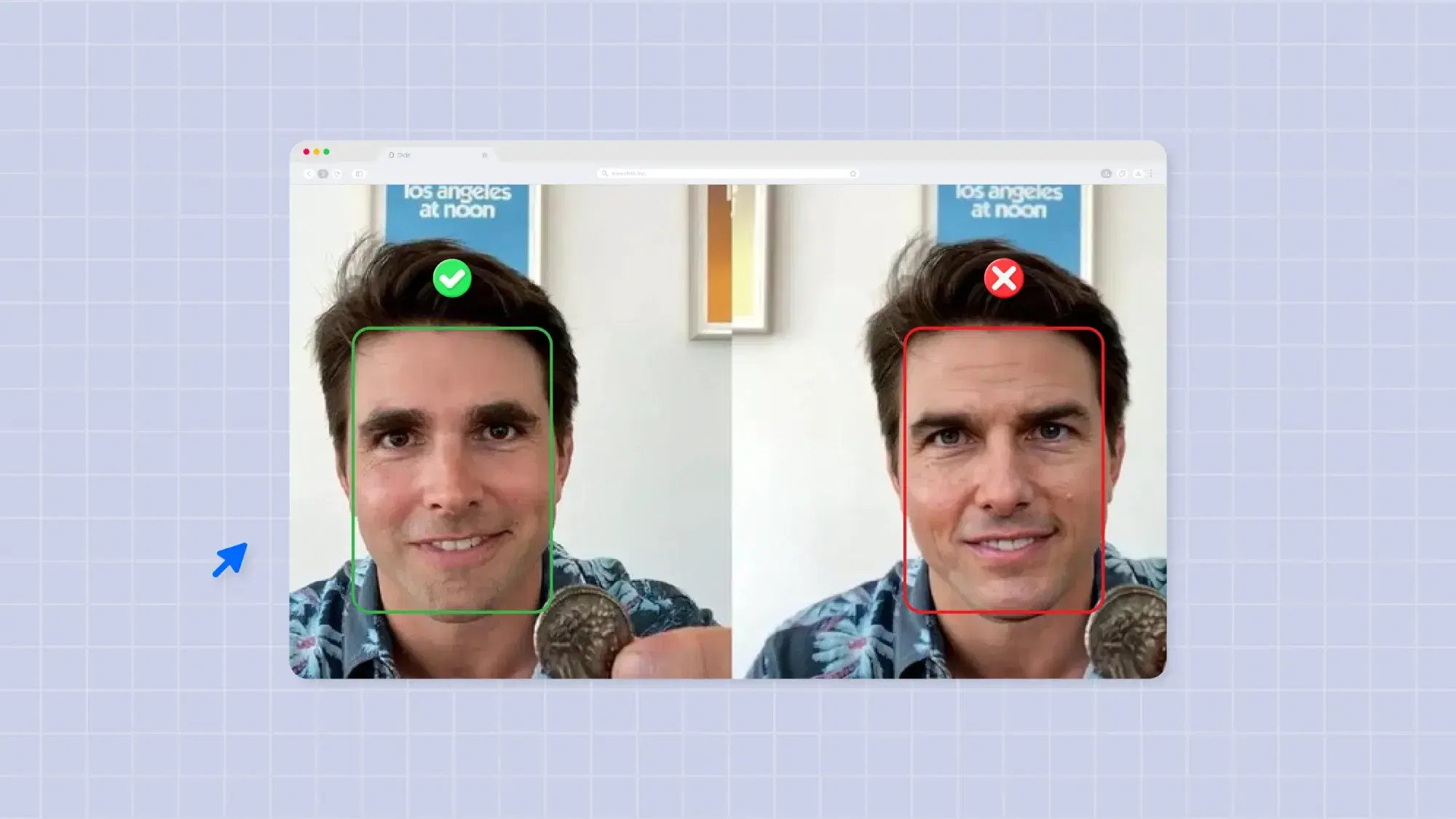

Đó là bước đầu tiên đảm bảo an toàn vận hành AI, để giải pháp công nghệ tiên tiến này không bị dùng vào mục đích xấu. Giải pháp thứ hai, là đạo luật có tên NO FAKES Act, do các thượng nghị sĩ Chris Coons, Marsha Blackburn, Amy Klobuchar và Thom Tillis đề xuất. Đạo luật này có những điều khoản với nội dung bảo vệ các cá nhân trước hành vi lạm dụng những ứng dụng làm giả khuôn mặt và giọng nói bằng thuật toán AI, tạo ra những hình ảnh giả mạo mà không được họ cho phép.

Từ những hình ảnh khiêu dâm được tạo ra nhờ công cụ AI, chèn gương mặt của những diễn viên nổi tiếng cho tới những nữ sinh vẫn còn đang trong độ tuổi vị thành niên, rồi cả những đoạn video clip làm giả những chính trị gia nổi tiếng nói những điều gây tranh cãi để định hướng dư luận, deepfake là vấn đề nan giải nhưng chưa có những đạo luật cụ thể để kiểm soát.

Khi đề xuất đạo luật NO FAKES Act, các nhà lập pháp Mỹ tuyên bố: “Đạo luật này sẽ ép các cá nhân và đơn vị, doanh nghiệp chịu trách nhiệm vì những thiệt hại gây ra trong quá trình tạo dựng, lưu trữ và chia sẻ phiên bản số của một cá nhân trình diễn dưới dạng sản phẩm nghe nhìn, hình ảnh hoặc thu âm, trong trường hợp cá nhân trong sản phẩm ấy không cho phép hoặc không làm việc để tạo ra chúng. Trong đó bao gồm cả những bản sao kỹ thuật số tạo ra bằng công nghệ trí tuệ nhân tạo. Dịch vụ lưu trữ trực tuyến, lưu trữ bản sao kỹ thuật số tạo ra trái phép này sẽ buộc phải gỡ bỏ những nội dung ấy theo yêu cầu của chủ sở hữu hình ảnh và giọng nói.”

Đạo luật NO FAKES chưa chắc đã truy quét được tận gốc vấn nạn deepfake đang tràn lan trên mạng internet hiện nay, đặc biệt là ở những khía cạnh mà các chính trị gia lo ngại, nhưng chí ít nó sẽ là văn bản pháp lý đầu tiên với chức năng kiểm soát tình trạng chế hình ảnh, video và âm thanh deepfake không có tác quyền hay sự cho phép, và có khả năng sẽ khiến tình trạng này giảm thiểu đáng kể.

Động thái thứ ba của các nhà lập pháp và quản lý bên Mỹ, theo chia sẻ của CEO Sam Altman của OpenAI, đó là công ty đã đồng ý cho liên đoàn AISIC tiếp cận phiên bản mô hình ngôn ngữ kế tiếp dùng để vận hành ChatGPT, để các nhà quản lý, các nhà nghiên cứu AI và các đơn vị trong ngành có thể duyệt trước, tìm ra những lỗ hổng có khả năng bị lợi dụng để tạo ra những nội dung có hại cho mọi người và cả xã hội, rồi OpenAI sẽ chỉnh sửa chúng trước khi vận hành chính thức:

“Nhóm kỹ sư của chúng tôi đang làm việc với Viện an toàn AI Mỹ dựa trên thỏa thuận rằng chúng tôi sẽ cung cấp phiên bản mô hình mới, để cả hai bên có thể hợp tác làm việc, hướng tới mục tiêu đẩy mạnh việc xác thực mô hình AI.”

Theo 9to5Mac

Hồi đầu năm nay, chính quyền tổng thống Joe Biden đã đề xuất một gói những quy định quản lý những sản phẩm và dịch vụ dựa trên công nghệ AI tạo sinh, do phó tổng thống Kamala Harris công bố. Ở thời điểm hiện tại, tuân thủ theo những quy định quản lý này vẫn đang là “tùy chọn”, không phải một đạo luật với những điều khoản mà những công ty tư nhân bắt buộc phải tuân thủ khi vận hành trên đất Mỹ. Nhưng hiện giờ, hầu hết mọi tập đoàn và đơn vị nghiên cứu AI lớn tại Mỹ đều tình nguyện tuân thủ những hướng dẫn quản lý vận hành AI an toàn: Apple, Amazon, Google, Meta, OpenAI và cả Microsoft nữa.

Đó là bước đầu tiên đảm bảo an toàn vận hành AI, để giải pháp công nghệ tiên tiến này không bị dùng vào mục đích xấu. Giải pháp thứ hai, là đạo luật có tên NO FAKES Act, do các thượng nghị sĩ Chris Coons, Marsha Blackburn, Amy Klobuchar và Thom Tillis đề xuất. Đạo luật này có những điều khoản với nội dung bảo vệ các cá nhân trước hành vi lạm dụng những ứng dụng làm giả khuôn mặt và giọng nói bằng thuật toán AI, tạo ra những hình ảnh giả mạo mà không được họ cho phép.

Từ những hình ảnh khiêu dâm được tạo ra nhờ công cụ AI, chèn gương mặt của những diễn viên nổi tiếng cho tới những nữ sinh vẫn còn đang trong độ tuổi vị thành niên, rồi cả những đoạn video clip làm giả những chính trị gia nổi tiếng nói những điều gây tranh cãi để định hướng dư luận, deepfake là vấn đề nan giải nhưng chưa có những đạo luật cụ thể để kiểm soát.

Khi đề xuất đạo luật NO FAKES Act, các nhà lập pháp Mỹ tuyên bố: “Đạo luật này sẽ ép các cá nhân và đơn vị, doanh nghiệp chịu trách nhiệm vì những thiệt hại gây ra trong quá trình tạo dựng, lưu trữ và chia sẻ phiên bản số của một cá nhân trình diễn dưới dạng sản phẩm nghe nhìn, hình ảnh hoặc thu âm, trong trường hợp cá nhân trong sản phẩm ấy không cho phép hoặc không làm việc để tạo ra chúng. Trong đó bao gồm cả những bản sao kỹ thuật số tạo ra bằng công nghệ trí tuệ nhân tạo. Dịch vụ lưu trữ trực tuyến, lưu trữ bản sao kỹ thuật số tạo ra trái phép này sẽ buộc phải gỡ bỏ những nội dung ấy theo yêu cầu của chủ sở hữu hình ảnh và giọng nói.”

Đạo luật NO FAKES chưa chắc đã truy quét được tận gốc vấn nạn deepfake đang tràn lan trên mạng internet hiện nay, đặc biệt là ở những khía cạnh mà các chính trị gia lo ngại, nhưng chí ít nó sẽ là văn bản pháp lý đầu tiên với chức năng kiểm soát tình trạng chế hình ảnh, video và âm thanh deepfake không có tác quyền hay sự cho phép, và có khả năng sẽ khiến tình trạng này giảm thiểu đáng kể.

Động thái thứ ba của các nhà lập pháp và quản lý bên Mỹ, theo chia sẻ của CEO Sam Altman của OpenAI, đó là công ty đã đồng ý cho liên đoàn AISIC tiếp cận phiên bản mô hình ngôn ngữ kế tiếp dùng để vận hành ChatGPT, để các nhà quản lý, các nhà nghiên cứu AI và các đơn vị trong ngành có thể duyệt trước, tìm ra những lỗ hổng có khả năng bị lợi dụng để tạo ra những nội dung có hại cho mọi người và cả xã hội, rồi OpenAI sẽ chỉnh sửa chúng trước khi vận hành chính thức:

“Nhóm kỹ sư của chúng tôi đang làm việc với Viện an toàn AI Mỹ dựa trên thỏa thuận rằng chúng tôi sẽ cung cấp phiên bản mô hình mới, để cả hai bên có thể hợp tác làm việc, hướng tới mục tiêu đẩy mạnh việc xác thực mô hình AI.”

Theo 9to5Mac

Chưa có bình luận nào!